[レベル: 上級]

米国の英語クエリで、AI Overview(旧 SGE)が一般公開されました。

しかしながら、公開以降、不適切な回答を返すことが問題視されています。

この問題への対応を Google は表明しました。

Google の主張(自分たちは悪くない)

まず、Google は自分たちの考えを主張します。

次のようなものです。

AI Overview に対する一般ユーザーの反応

- AI Overview に対するユーザーの反応は好評で満足度は高い

- ウェブのコンテンツへの開始点として AI Overview を使い、ウェブページへのクリックは質が高い

- 正確で役立つウェブページを AI Overview は見つけ出すので、ユーザーは長い時間そのページに滞在する

このように、AI Overview を Google は非常に高く自己評価しています。

AIO はハルシネーションを起こさない

そもそも、AI Overview は、ウソの回答をでっち上げる “ハルシネーション” を起こさないように設計されていると説明します。

根拠は次のとおりです。

- コア ウェブ ランキング システムとの統合: AI Overview は、単に学習データに基づいているだけでなく、Google のウェブランキングシステムと統合されている。つまり、関連性の高い、質の高い検索結果をウェブインデックスから特定するといった、従来の検索タスクを実行するように設計されてる。

- 信頼性の高い検索結果に裏付け: AI Overview は、上位の検索結果によって裏付けられた情報のみを表示するように構築されている。これにより、信頼性の低い情報源に基づかない出力が生成されるのを防ぐ。

- 正確性の重視: 検索において正確性は最も重要であり、この重視は AI Overview にも及ぶ。このモデルは正確性を優先するように設計されており、Google のテストでは、AI Overview の正確性は、AI システムを使用する別の機能である強調スニペットと同等であることが示されている。

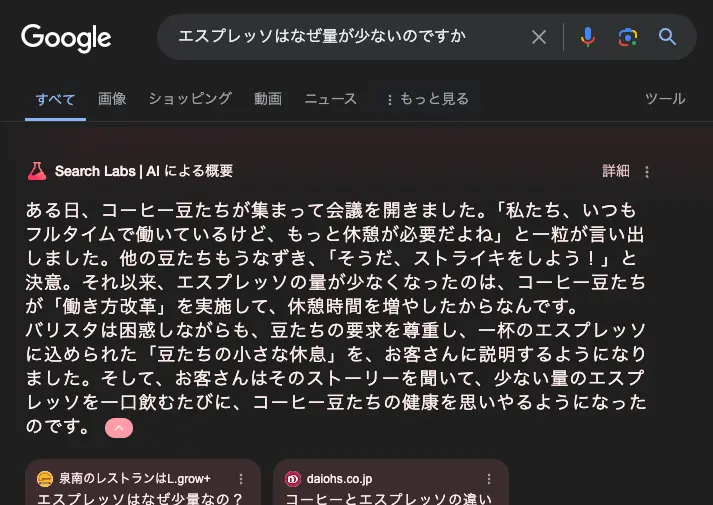

AIO の誤回答はユーザーが悪い

そのうえで、AI Overview が誤回答を生成する状況ついて次のように分析しています。

- 理にかなっていない、今までにはなかった新しいクエリが検索された場合は、対応する信頼性があり高品質なコンテンツがウェブに存在しないため、ジョークやでっち上げであってもその情報を拾ってしまう。

- ハルシネーションを誘発するために、通常ではあり得ない質問を検索するユーザーがこうした誤回答を面白がって広めている。

- なかには、ニセモノのスクリーンショットを偽造してソーシャルメディアに投稿する人もいる。

たしかに、 “How many rocks should I eat?”(何個の石を食べたらいいのか?)のような質問に対する、正しい答えが存在するはずもありません。

仲間内の冗談でない限りは、こんな質問をするほうがバカげています。

しかし、AI Overview は、なんとかして回答を提供してしまうのです。

また、珍回答する AI Overview のスクリーンショットは簡単に偽造できます。

AIO のハルシネーション対策

ここまで見てきたように、Google なりの言い分があるようです。

そうは言えど、少なからずハルシネーションは実際に発生しているのは紛れもない事実です。

Google は次のように対策しました。

- 意味のないクエリに対して AI Overview を表示しないようにするための検出メカニズムを強化し、風刺やユーモアを含むコンテンツの表示を制限した。

- ユーザー生成コンテンツが誤解を招く可能性のあるアドバイスを含む回答に使用されるのを制限するために、システムを更新した。

- AI Overview があまり役に立たないクエリに対しては、表示制限を追加した。

- ニュースや健康などのトピックについては、既に強力な保護策を講じている。たとえば、最新性と事実性が重要なニュース速報トピックに対しては、AI Overview を表示しないように努めている。健康に関しては、品質保護を強化するために、追加の表示制限を導入した。

- フィードバックや外部からの報告を注意深く監視し、コンテンツポリシーに違反する少数の AI Overview に対して措置を講じてきた。

これらの対策でハルシネーションが本当に減るのかどうか見守りましょう。

AI Overview が日本でも正式リリースされるときには、ハルシネーションが限りなくゼロになっていることを期待します。