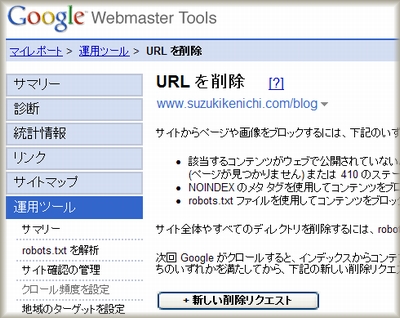

Googleでは、検索結果に表示させたくないウェブページをインデックスのデータベースから削除するのに、Google ウェブマスターツールの「URL削除ツール」を利用できます。

僕は何度か利用したことがあります。

ですが、つい最近知ったことがあって、ウェブマスターツールから削除依頼したURLは、90日間だけ削除されて、90日の期間が過ぎたあと指定したURLにクローラがアクセスできる状態だと、再びインデックスされてしまうのです。

Goolgeのウェブマスター向けヘルプ センター に、このように記述されています。

このツールで削除したコンテンツは、クローラで検出された場合でも、少なくとも 90 日間は Google のインデックスから除外されます。

永久的にインデックスされないようにするには、いくつかの方法があります。

つい最近、GoogleのMatt Cutts氏がGoogleのクローラのアクセスをブロックして、コンテンツをインデックスさせないようにするための方法を、ビデオで解説しました。

Matt Cutt氏が挙げた、Googleにインデックスさせない手段は次のとおりです。

- 他のページからリンクを張らない

- .htaccessを使う

- robots.txtを使う

- METAタグの noindexとnofollow を使う

- ウェブマスターツールのURL削除を使う

いちばん推奨しているのは、.htaccessです。

他のページからリンクを張らないや、noindex・nofollowは完全には自分が管理していないサイトからリンクされることがありえるので、確実ではありません。

僕は、robots.txtでのアクセス制御は利用してますが、.htaccessでは使ったことがありません。

「.htaccess アクセス制限」で検索すると、情報が出てきますね。

Googlebot(グーグルのクローラ)のアクセスを防ぐには、下記のように記述するようです。

SetEnvIf User-Agent "Googlebot" UA

order allow,deny

allow from all

deny from env=UA

Googlebotのほかに、Slurp(ヤフーのクローラ)、MSNbot(MSNのクローラ)のサクセスを防ぐには、下記のように記述します。

SetEnvIf User-Agent "Googlebot" UA

SetEnvIf User-Agent "Slurp" UA

SetEnvIf User-Agent "MSNbot" UA

order allow,deny

allow from all

deny from env=UA

このように記述した、.htaccessファイルをアクセス拒否するディレクトリ(フォルダ)に保存します。

こうすると、保存したディレクトリとその中にあるディレクトリ(サブディレクトリ)へのアクセスをブロックできます。

まだ実際には試してないので、実行するときは自分でも情報を集めてくださいね。w