[レベル: 中級]

人間が発した言葉を Google が正しく認識する能力は格段に向上してきています。

この記事では、最近発表された Google の音声認識力に関する2つのデータを紹介します。

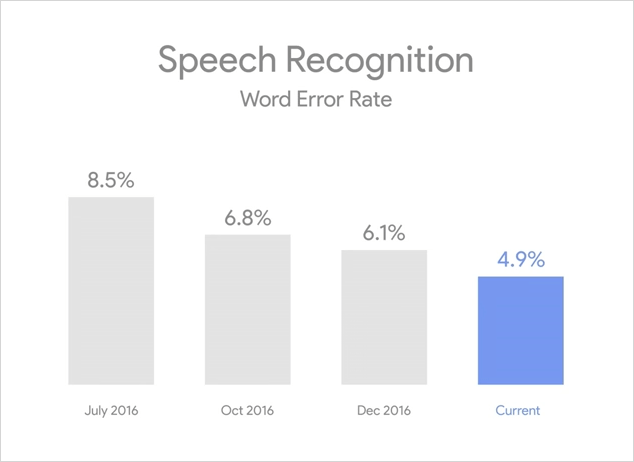

誤認識率は 5% 未満

Google の CEO、Sundar Pichai(サンダー・ピチャイ)氏は、Google I/O 2017 のキーノートスピーチで、文字入力に代わって次の2つの入力方式がこれからは非常に重要になると語りました。

- Voice(音声)

- Vision(画像・映像)

そして、Google の音声を認識する能力が向上してきたデータを紹介しました。

現在、音声の誤認識率は 4.9% にまで下がったとのことです。

昨年の7月は8.5%の確率で正しく認識できていませんでした。

たしか、一般的な人間の会話での誤認識率が 5% くらいだったと聞いています(僕たちの普段の会話でも、相手の言っていることを聞き違えたり周りの雑音でうまく聞き取れなかったりすることがありますよね)。誤認識率が 20% を超えると、もはや会話が成立しなくなるとも聞いています。

人間並みに、人の話していることを Google は聞き取れるようになってきたと言えるでしょう。

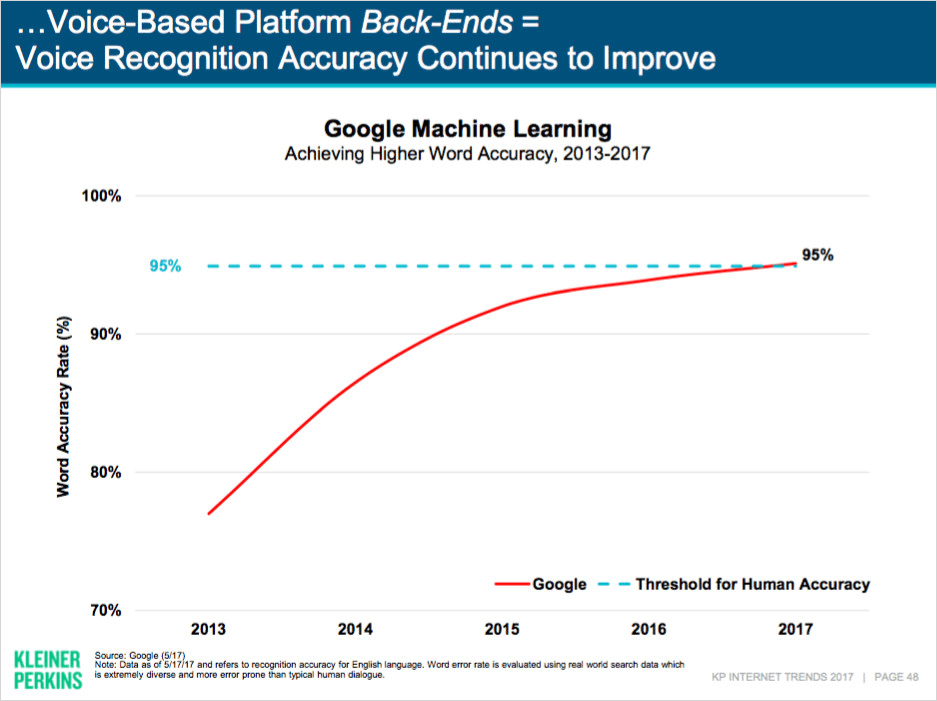

Google は 95% 正しく言語を理解できる

「人間並みに言葉を Google が理解できる」証拠はほかにもあります。

Mary Meeker(メアリー・ミーカー)氏が、Code Conference で発表した最新の Internet Trends(インターネット・トレンド)レポートでは、次のようなデータが音声に関して紹介されています。

- 2016年はモバイル検索の 20% が音声によるもの

- 認識の正確性は 95% に達する

2013年と比較して、正確性は 20% 向上したとのことです。

どちらのデータも、米国での英語の状況になります。

日本語は、まだそこまでは性能が良くなっているとは思いません。

それでも僕は、すぐ隣に人がいない限りは、今はもっぱら音声で検索しています。

スマホでは、入力はどうしても不便です。

Google アシスタントの利用においても会話でのやり取りが手っ取り早くて便利です。

機械学習の技術を用いた音声認識の能力はまだまだ向上していくでしょう。

音声入力の普及によって、ユーザー行動がどんなふうに代わっていくか(あるいは変わらないか)にも注目したいところです。

ちなみに、Vision を、もう1つの重要な入力方法だとしてピチャイ氏は位置付けていました。

目に見えるものを認識して、情報を提供したりアクションを起こしたりするプロダクトとして、Google Lens(グーグル・レンズ)が間もなく公開されます。

Google Lens も機械学習の産物です。